Quer insights mais inteligentes em sua caixa de entrada? Inscreva -se para que nossos boletins semanais obtenham apenas o que importa para a IA, dados e líderes de segurança corporativos. Inscreva -se agora

Uma nova técnica evolutiva da AI Lab, com sede no Japão, Sakana AI, permite que os desenvolvedores aumentem as capacidades dos modelos de IA sem treinamento caro e processos de ajuste fino. A técnica, chamada de fusão do modelo de nichos naturais (M2N2), supera as limitações de outros métodos de fusão do modelo e pode até desenvolver novos modelos inteiramente do zero.

O M2N2 pode ser aplicado a diferentes tipos de modelos de aprendizado de máquina, incluindo grandes modelos de idiomas (LLMS) e geradores de texto para imagem. Para empresas que desejam criar soluções de IA personalizadas, a abordagem oferece uma maneira poderosa e eficiente de criar modelos especializados, combinando os pontos fortes das variantes de código aberto existentes.

O que é a fusão do modelo?

A fusão do modelo é uma técnica para integrar o conhecimento de vários modelos especializados de IA em um modelo único e mais capaz. Em vez de ajustar fino, que refina um único modelo pré-treinado usando novos dados, a fusão combina os parâmetros de vários modelos simultaneamente. Esse processo pode consolidar uma riqueza de conhecimento em um ativo sem exigir treinamento caro baseado em gradiente ou acesso aos dados de treinamento original.

Para equipes corporativas, isso oferece várias vantagens práticas sobre o ajuste tradicional. Nos comentários do VentureBeat, os autores do artigo disseram que a fusão do modelo é um processo sem gradiente que requer apenas passes avançados, tornando-o computacionalmente mais barato que o ajuste fino, o que envolve atualizações de gradiente dispendiosas. A fusão também evita a necessidade de dados de treinamento cuidadosamente equilibrados e atenuam o risco de “esquecimento catastrófico”, onde um modelo perde suas capacidades originais depois de aprender uma nova tarefa. A técnica é especialmente poderosa quando os dados de treinamento para modelos especializados não estão disponíveis, pois a fusão requer apenas o modelo pesa.

Ai escala atinge seus limites

Capitões de energia, custos crescentes de token e atrasos de inferência estão remodelando a IA corporativa. Junte -se ao nosso salão exclusivo para descobrir como são as principais equipes:

- Transformando energia em uma vantagem estratégica

- Arquitetagem Inferência eficiente para ganhos reais de rendimento

- Desbloqueando o ROI competitivo com sistemas de IA sustentáveis

Prenda seu lugar para ficar à frente: https://bit.ly/4mwgngo

As abordagens iniciais para a fusão de modelos exigiram esforço manual significativo, à medida que os desenvolvedores ajustavam os coeficientes por tentativa e erro para encontrar a mistura ideal. Mais recentemente, os algoritmos evolutivos ajudaram a automatizar esse processo pesquisando a combinação ideal de parâmetros. No entanto, permanece uma etapa manual significativa: os desenvolvedores devem definir conjuntos fixos para parâmetros fascinantes, como camadas. Essa restrição limita o espaço de pesquisa e pode impedir a descoberta de combinações mais poderosas.

Como o M2N2 funciona

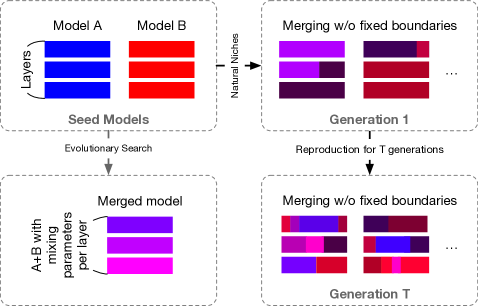

M2N2 aborda essas limitações inspirando -se nos princípios evolutivos na natureza. O algoritmo possui três recursos principais que permitem explorar uma gama mais ampla de possibilidades e descobrir combinações de modelos mais eficazes.

Primeiro, o M2N2 elimina limites fixos de mesclagem, como blocos ou camadas. Em vez de agrupar parâmetros por camadas predefinidas, ele usa “pontos divididos” flexíveis e “ração de mistura” para dividir e combinar modelos. Isso significa que, por exemplo, o algoritmo pode mesclar 30% dos parâmetros em uma camada do modelo A com 70% dos parâmetros da mesma camada no modelo B. O processo começa com um “arquivo” de modelos de sementes. A cada etapa, o M2N2 seleciona dois modelos do arquivo, determina uma proporção de mistura e um ponto de divisão e os mescla. Se o modelo resultante tiver um bom desempenho, ele será adicionado de volta ao arquivo, substituindo um mais fraco. Isso permite que o algoritmo explore combinações cada vez mais complexas ao longo do tempo. Como observam os pesquisadores, “essa introdução gradual da complexidade garante uma gama mais ampla de possibilidades, mantendo a tratabilidade computacional”.

Segundo, o M2N2 gerencia a diversidade de sua população modelo através da concorrência. Para entender por que a diversidade é crucial, os pesquisadores oferecem uma analogia simples: “Imagine a fusão de duas folhas de respostas para um exame … se ambas as folhas tiverem exatamente as mesmas respostas, combiná -las não fará melhorias. Mas se cada folha tiver respostas corretas para perguntas diferentes, mesclá -las proporcionar um resultado muito mais forte.” A fusão do modelo funciona da mesma maneira. O desafio, no entanto, é definir que tipo de diversidade é valiosa. Em vez de confiar em métricas artesanais, o M2N2 simula a concorrência por recursos limitados. Essa abordagem inspirada na natureza recompensa os modelos naturalmente com habilidades únicas, pois eles podem “explorar recursos não contestados” e resolver problemas que outros não podem. Esses especialistas em nicho, observam os autores, são os mais valiosos para a fusão.

Terceiro, o M2N2 usa uma heurística chamada “atração” para emparelhar modelos para fusão. Em vez de simplesmente combinar os modelos de melhor desempenho, como em outros algoritmos de fusão, ele os combina com base em seus pontos fortes complementares. Uma “pontuação de atração” identifica pares em que um modelo tem um bom desempenho nos pontos de dados que o outro acha desafiador. Isso melhora a eficiência da pesquisa e a qualidade do modelo final mesclado.

M2N2 em ação

Os pesquisadores testaram M2N2 em três domínios diferentes, demonstrando sua versatilidade e eficácia.

O primeiro foi um experimento de pequena escala que evoluiu, classificadores de imagem baseados em rede neural do zero no conjunto de dados MNIST. O M2N2 alcançou a maior precisão do teste por uma margem substancial em comparação com outros métodos. Os resultados mostraram que seu mecanismo de preservação da diversidade foi fundamental, permitindo que ele mantenha um arquivo de modelos com forças complementares que facilitaram a fusão efetiva enquanto descartavam sistematicamente soluções mais fracas.

Em seguida, eles aplicaram M2N2 ao LLMS, combinando um modelo de especialista em matemática (WizardMath-7b) com um especialista em agêntico (agentevol-7b), ambos baseados na arquitetura LLAMA 2. O objetivo era criar um único agente que se destacou nos problemas de matemática (conjunto de dados GSM8K) e tarefas baseadas na Web (conjunto de dados da webshop). O modelo resultante alcançou um forte desempenho nos dois benchmarks, mostrando a capacidade do M2N2 de criar modelos poderosos e multi-qualificados.

Finalmente, a equipe fundiu modelos de geração de imagens baseados em difusão. Eles combinaram um modelo treinado em avisos japoneses (JSDXL) com três modelos de difusão estável treinados principalmente em avisos em inglês. O objetivo era criar um modelo que combinasse os melhores recursos de geração de imagens de cada modelo de semente, mantendo a capacidade de entender os japoneses. O modelo mesclado não apenas produziu mais imagens fotorrealistas com melhor entendimento semântico, mas também desenvolveu uma capacidade bilíngue emergente. Poderia gerar imagens de alta qualidade a partir de avisos em inglês e japonês, mesmo que tenha sido otimizado exclusivamente usando legendas japonesas.

Para empresas que já desenvolveram modelos especializados, o caso de negócios para fusão é atraente. Os autores apontam para novos recursos híbridos que seriam difíceis de alcançar de outra forma. Por exemplo, a fusão de um LLM ajustou os arremessos de vendas persuasivos com um modelo de visão treinado para interpretar as reações dos clientes, pode criar um único agente que adapte seu argumento em tempo real com base no feedback de vídeo ao vivo. Isso desbloqueia a inteligência combinada de vários modelos com o custo e a latência de executar apenas um.

Olhando para o futuro, os pesquisadores veem técnicas como o M2N2 como parte de uma tendência mais ampla em direção a “Model Fusion”. Eles imaginam um futuro em que as organizações mantêm ecossistemas inteiros de modelos de IA que estão em evolução continuamente e se fundindo para se adaptar a novos desafios.

“Pense nisso como um ecossistema em evolução, onde os recursos são combinados conforme necessário, em vez de construir um monólito gigante do zero”, sugerem os autores.

Os pesquisadores divulgaram o código do M2N2 no Github.

O maior obstáculo a esse ecossistema de IA dinâmico e auto-aprimorado, acredita os autores, não é técnico, mas organizacional. “Em um mundo com um grande ‘modelo mesclado’ composto por componentes de código aberto, comercial e personalizado, garantindo que a privacidade, a segurança e a conformidade seja um problema crítico.” Para as empresas, o desafio será descobrir quais modelos podem ser absorvidos com segurança e eficácia em sua pilha de IA em evolução.

Insights diários sobre casos de uso de negócios com VB diariamente

Se você deseja impressionar seu chefe, o VB Daily o cobriu. Damos a você uma informação interna sobre o que as empresas estão fazendo com a IA generativa, desde mudanças regulatórias a implantações práticas, para que você possa compartilhar informações para o ROI máximo.

Leia nossa Política de Privacidade

Obrigado por assinar. Confira mais boletins de VB aqui.

Ocorreu um erro.

Fonte ==> Cyberseo