As duas grandes histórias da IA em 2026 até agora foram o incrível aumento no uso e elogios do Claude Code da Anthropic e um grande aumento semelhante na adoção dos usuários da família de modelos de IA Gemini 3 do Google lançada no final do ano passado – o último dos quais inclui Nano Banana Pro (também conhecido como Gemini 3 Pro Image), um modelo de geração de imagens poderoso, rápido e flexível que renderiza infográficos complexos e com muito texto com rapidez e precisão, tornando-o uma excelente opção para uso empresarial (pense: material colateral, treinamentos, onboarding, estacionário, etc).

Mas é claro que ambas são ofertas proprietárias. E, no entanto, os rivais do código aberto não ficaram muito atrás.

Esta semana, obtivemos uma nova alternativa de código aberto ao Nano Banana Pro na categoria de geradores de imagens precisos e com muito texto: GLM-Image, um novo modelo de código aberto de 16 bilhões de parâmetros da startup chinesa recentemente pública Z.ai.

Ao abandonar o padrão da indústria "difusão pura" arquitetura que alimenta a maioria dos principais modelos de gerador de imagem em favor de um design híbrido auto-regressivo (AR) + difusão, o GLM-Image alcançou o que anteriormente se pensava ser o domínio de modelos proprietários fechados: desempenho de última geração na geração de recursos visuais com muito texto e informações densas, como infográficos, slides e diagramas técnicos.

Ele até supera o Nano Banana Pro do Google no compartilhado por z.ai – embora, na prática, meu uso rápido tenha descoberto que ele é muito menos preciso no seguimento de instruções e na renderização de texto (e outros usuários parecem concordar).

Mas para empresas que buscam alternativas econômicas, personalizáveis e licenciadas de maneira amigável aos modelos proprietários de IA, o GLM-Image da z.ai pode ser "bom o suficiente" ou então alguns para assumir o trabalho de gerador de imagem primário, dependendo de seus casos de uso, necessidades e requisitos específicos.

A referência: derrubando o gigante proprietário

O argumento mais convincente para o GLM-Image não é a sua estética, mas a sua precisão. No benchmark CVTG-2k (Complex Visual Text Generation), que avalia a capacidade de um modelo de renderizar texto preciso em múltiplas regiões de uma imagem, GLM-Image obteve uma média de precisão de palavras de 0,9116.

Para colocar esse número em perspectiva, Nano Banana 2.0, também conhecido como Pro – frequentemente citado como referência em confiabilidade empresarial – obteve pontuação de 0,7788. Este não é um ganho marginal; é um salto geracional no controle semântico.

Embora o Nano Banana Pro mantenha uma ligeira vantagem na geração de texto longo em inglês de fluxo único (0,9808 vs. 0,9524 do GLM-Image), ele falha significativamente quando a complexidade aumenta.

À medida que o número de regiões de texto aumenta, a precisão do Nano Banana permanece na casa dos 70, enquanto o GLM-Image mantém uma precisão superior a 90%, mesmo com vários elementos de texto distintos.

Para casos de uso corporativo – onde um slide de marketing precisa de um título, três marcadores e uma legenda simultaneamente – essa confiabilidade é a diferença entre um ativo pronto para produção e uma alucinação.

Infelizmente, meu próprio uso de uma inferência de demonstração do GLM-Image no Hugging Face provou ser menos confiável do que os benchmarks podem sugerir.

Meu prompt para gerar um "infográfico rotulando todas as principais constelações visíveis no Hemisfério Norte dos EUA agora em 14 de janeiro de 2026 e colocando imagens desbotadas de seus homônimos atrás dos diagramas de linhas de conexão estelar" não resultou no que pedi, em vez disso cumpriu talvez 20% ou menos do conteúdo especificado.

Mas o Nano Banana Pro do Google lidou com isso como um campeão, como você verá abaixo:

É claro que grande parte disso se deve, sem dúvida, ao fato de o Nano Banana Pro estar integrado à pesquisa do Google, para que possa procurar informações na web em resposta à minha solicitação, enquanto o GLM-Image não está e, portanto, provavelmente requer instruções muito mais específicas sobre o texto real e outros conteúdos que a imagem deve conter.

Mas ainda assim, uma vez que você esteja acostumado a digitar algumas instruções simples e obter uma imagem totalmente pesquisada e bem preenchida por meio do último, é difícil imaginar a implantação de uma alternativa abaixo da média, a menos que você tenha requisitos muito específicos em relação a custo, residência de dados e segurança – ou as necessidades de personalização de sua organização sejam tão grandes.

Além disso, Nano Banana Pro ainda superou GLM-Image em termos de estética pura — utilizando o índice de referência OneIG, Nano Banana 2.0 está em 0,578 vs. GLM-Image em 0,528 – e, de fato, como indica a arte do cabeçalho superior deste artigo, o GLM-Image nem sempre renderiza uma imagem tão nítida, detalhada e agradável quanto o gerador do Google.

A mudança arquitetônica: por que "Híbrido" Assuntos

Por que o GLM-Image tem sucesso onde os modelos de difusão pura falham? A resposta está na decisão de Z.ai de tratar a geração de imagens primeiro como um problema de raciocínio e depois como um problema de pintura.

Modelos de difusão latente padrão (como Difusão Estável ou Fluxo) tentam lidar com a composição global e a textura de granulação fina simultaneamente.

Isto muitas vezes leva a "deriva semântica," onde o modelo esquece instruções específicas (como "coloque o texto no canto superior esquerdo"), pois se concentra em fazer com que os pixels pareçam realistas.

A GLM-Image separa esses objetivos em dois "cérebros" totalizando 16 bilhões de parâmetros:

-

O Gerador Auto-Regressivo (O "Arquiteto"): Inicializado a partir do modelo de linguagem GLM-4-9B da Z.ai, este módulo de 9 bilhões de parâmetros processa o prompt logicamente. Não gera pixels; em vez disso, ele produz "fichas visuais"—especificamente tokens VQ semânticos. Esses tokens atuam como um modelo compactado da imagem, bloqueando o layout, o posicionamento do texto e os relacionamentos dos objetos antes que um único pixel seja desenhado. Isso aproveita o poder de raciocínio de um LLM, permitindo que o modelo "entender" instruções complexas (por exemplo, "Um tutorial de quatro painéis") de uma forma que os preditores de ruído de difusão não conseguem.

-

O decodificador de difusão (o "Pintor"): Depois que o layout é bloqueado pelo módulo AR, um decodificador Diffusion Transformer (DiT) de 7 bilhões de parâmetros assume o controle. Baseado na arquitetura CogView4, este módulo preenche os detalhes de alta frequência – textura, iluminação e estilo.

Ao separar o "o que" (AR) do "como" (Difusão), GLM-Image resolve o "conhecimento denso" problema. O módulo AR garante que o texto seja escrito corretamente e colocado com precisão, enquanto o módulo Difusão garante que o resultado final pareça fotorrealista.

Treinando o Híbrido: Uma Evolução em Vários Estágios

O ingrediente secreto do desempenho do GLM-Image não é apenas a arquitetura; é um currículo de treinamento altamente específico e em vários estágios que força o modelo a aprender a estrutura antes dos detalhes.

O processo de treinamento começou congelando a camada de incorporação de palavras de texto do modelo GLM-4 original enquanto treinava um novo "incorporação de palavras de visão" camada e uma cabeça LM de visão especializada.

Isso permitiu que o modelo projetasse tokens visuais no mesmo espaço semântico do texto, ensinando efetivamente o LLM a "falar" em imagens. Crucialmente, Z.ai implementou MRoPE (Multidimensional Rotary Positional Embedding) para lidar com a complexa intercalação de texto e imagens necessária para geração modal mista.

O modelo foi então submetido a uma estratégia de resolução progressiva:

-

Estágio 1 (256px): O modelo foi treinado em sequências de 256 tokens de baixa resolução usando uma ordem simples de varredura raster.

-

Estágio 2 (512px – 1024px): À medida que a resolução aumentou para um nível misto (512px a 1024px), a equipe observou uma queda na controlabilidade. Para corrigir isso, eles abandonaram a simples varredura em favor de uma estratégia de geração progressiva.

Neste estágio avançado, o modelo gera primeiro aproximadamente 256 "tokens de layout" de uma versão reduzida da imagem alvo.

Esses tokens atuam como uma âncora estrutural. Ao aumentar o peso do treinamento nesses tokens preliminares, a equipe forçou o modelo a priorizar o layout global – onde as coisas estão – antes de gerar os detalhes de alta resolução. É por isso que a GLM-Image se destaca em cartazes e diagramas: ela "esboços" o layout primeiro, garantindo que a composição seja matematicamente correta antes de renderizar os pixels.

Análise de licenciamento: uma vitória permissiva, embora um pouco ambígua, para as empresas

Para CTOs empresariais e equipes jurídicas, a estrutura de licenciamento do GLM-Image é uma vantagem competitiva significativa sobre APIs proprietárias, embora venha com uma pequena ressalva em relação à documentação.

A ambigüidade: Há uma ligeira discrepância nos materiais de lançamento. O repositório Hugging Face do modelo marca explicitamente os pesos com a licença MIT.

No entanto, o repositório GitHub e a documentação que acompanham fazem referência à Licença Apache 2.0.

Por que isso ainda é uma boa notícia: apesar da incompatibilidade, ambas as licenças são as "padrão ouro" para código aberto amigável às empresas.

-

Viabilidade Comercial: Tanto o MIT quanto o Apache 2.0 permitem uso comercial, modificação e distribuição irrestritos. Ao contrário do "trilho aberto" licenças comuns em outros modelos de imagem (que muitas vezes restringem casos de uso específicos) ou "apenas para pesquisa" licenças (como os primeiros lançamentos do LLaMA), o GLM-Image é efetivamente "aberto para negócios" imediatamente.

-

A vantagem do Apache (se aplicável): Se o código se enquadrar no Apache 2.0, isso será particularmente benéfico para grandes organizações. O Apache 2.0 inclui uma cláusula explícita de concessão de patente, o que significa que, ao contribuir ou usar o software, os contribuidores concedem uma licença de patente aos usuários. Isso reduz o risco de futuros litígios sobre patentes – uma grande preocupação para as empresas que criam produtos com base em bases de código de código aberto.

-

Não "Infecção": Nenhuma licença é "copyleft" (como GPL). Você pode integrar o GLM-Image em um fluxo de trabalho ou produto proprietário sem ser forçado a abrir o código-fonte de sua própria propriedade intelectual.

Para desenvolvedores, a recomendação é simples: trate os pesos como MIT (de acordo com o repositório que os hospeda) e o código de inferência como Apache 2.0. Ambos os caminhos abrem caminho para hospedagem interna, ajuste fino de dados confidenciais e construção de produtos comerciais sem contrato de dependência de fornecedor.

O "Por que agora" para operações empresariais

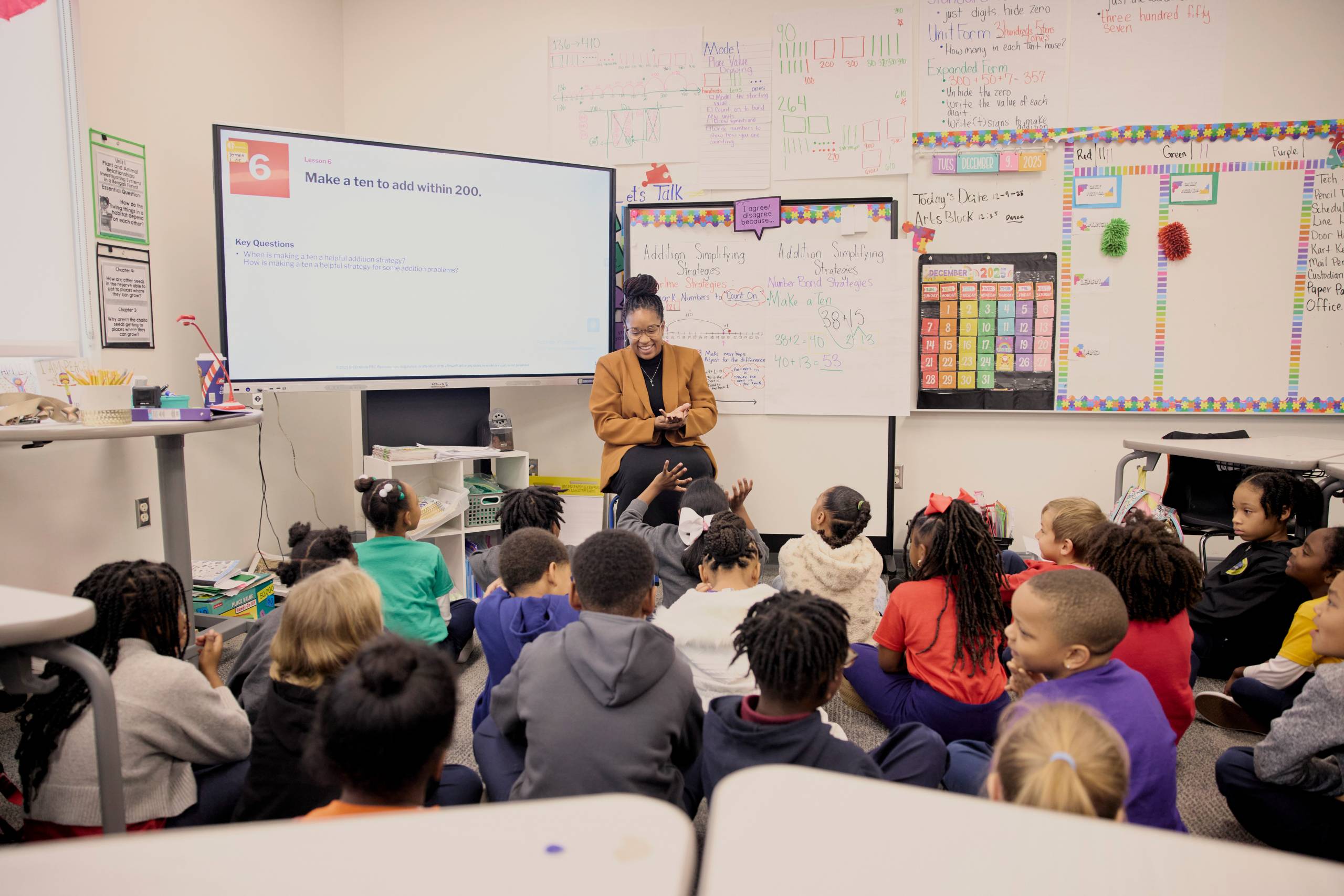

Para o tomador de decisão empresarial, o GLM-Image chega a um ponto de inflexão crítico. As empresas estão indo além do uso de IA generativa para cabeçalhos abstratos de blogs e entrando em território funcional: localização multilíngue de anúncios, geração automatizada de maquetes de UI e materiais educacionais dinâmicos.

Nesses fluxos de trabalho, uma taxa de erro de 5% na renderização de texto é um bloqueador. Se um modelo gerar um belo slide, mas digitar incorretamente o nome do produto, o ativo será inútil. Os benchmarks sugerem que o GLM-Image é o primeiro modelo de código aberto a ultrapassar o limite de confiabilidade para essas tarefas complexas.

Além disso, o licenciamento permissivo altera fundamentalmente a economia da implantação. Enquanto o Nano Banana Pro prende as empresas a uma estrutura de custos de API por chamada ou a contratos de nuvem restritivos, o GLM-Image pode ser auto-hospedado, ajustado em ativos de marca proprietários e integrado em pipelines seguros e isolados, sem preocupações com vazamento de dados.

O problema: requisitos pesados de computação

A compensação para essa capacidade de raciocínio é a intensidade da computação. A arquitetura de modelo duplo é pesada. A geração de uma única imagem de 2048×2048 requer aproximadamente 252 segundos em uma GPU H100. Isso é significativamente mais lento do que modelos de difusão menores e altamente otimizados.

No entanto, para ativos de alto valor – onde a alternativa é um designer humano passar horas no Photoshop – essa latência é aceitável.

Z.ai também oferece uma API gerenciada por US$ 0,015 por imagem, fornecendo uma ponte para equipes que desejam testar os recursos sem investir imediatamente em clusters H100.

GLM-Image é um sinal de que a comunidade de código aberto não é mais apenas um seguidor rápido de laboratórios proprietários; em sectores verticais específicos e de elevado valor, como a geração com grande densidade de conhecimento, estão agora a definir o ritmo. Para a empresa, a mensagem é clara: se o seu gargalo operacional é a confiabilidade do conteúdo visual complexo, a solução não é mais necessariamente um produto fechado do Google – pode ser um modelo de código aberto que você mesmo pode executar.

Fonte ==> Cyberseo